梦晨 发自 凹非寺

量子位 报道 | 公众号 QbitAI

AlphaGo在围棋领域所向披靡,却仍有质疑之声:难道AI只能挑战围棋,那它能否在斗地主上也能一展身手呢?

试试就试试。

快手团队所开发的斗地主人工智能系统被命名为DouZero,其含义是指这款AI如同AlphaZero一般,是从零基础开始进行训练的,无需借助任何人类已有的知识。

仅利用四块GPU,经过短短数日的训练,便在Botzone排行榜上斗地主AI的344名参赛者中脱颖而出,名列第一。

而且还有在线试玩(链接在文章最后),手机也能运行。

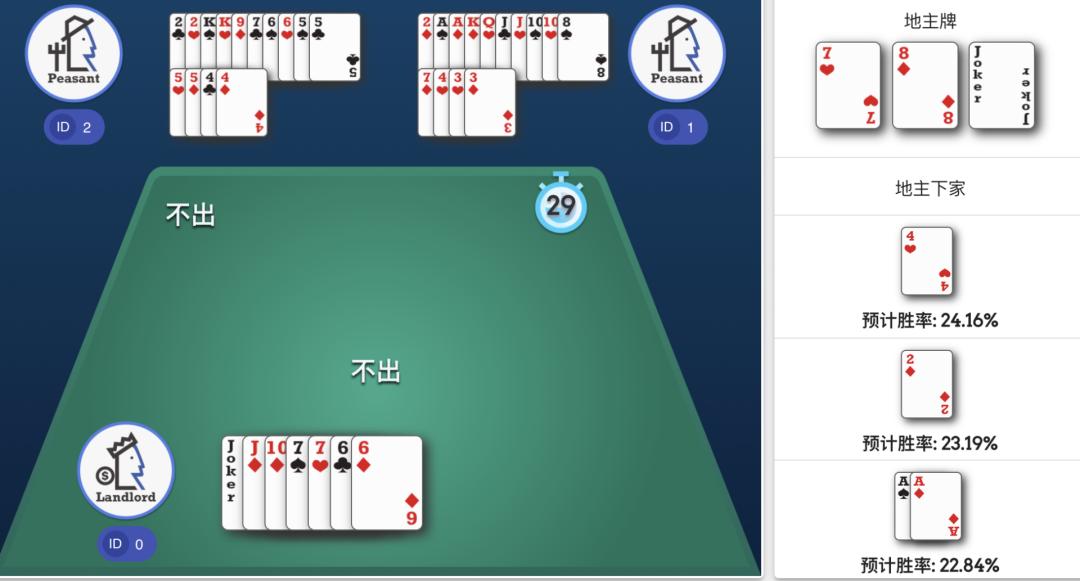

在在线试玩环节中,玩家得以体验三人斗地主游戏,他们可自主选择成为地主、地主的上手或下手角色。

挑选一位本地高手进行对弈,激活AI的牌面展示功能,这样有助于更直观地了解其决策思路。此外,你还可以调整AI的思考时长,系统默认设置为三秒钟。

在AI的回合,会显示面临的决策和每种打法的预测胜率。

有时候,我们发现AI并非仅仅选取当前胜率最高的策略,它还展现出一种更为宏观的思考方式。

斗地主对AI来说,很难

从博弈论的角度看,斗地主是“不完全信息博弈”。

围棋是一种棋类游戏,其中所有棋子均置于棋盘之上,使得对弈双方均可清晰目睹棋局全貌,属于一种信息完全透明的博弈形式。

斗地主游戏中,每位玩家都无法窥见他人的牌面,这对人工智能而言,无疑增加了难度。

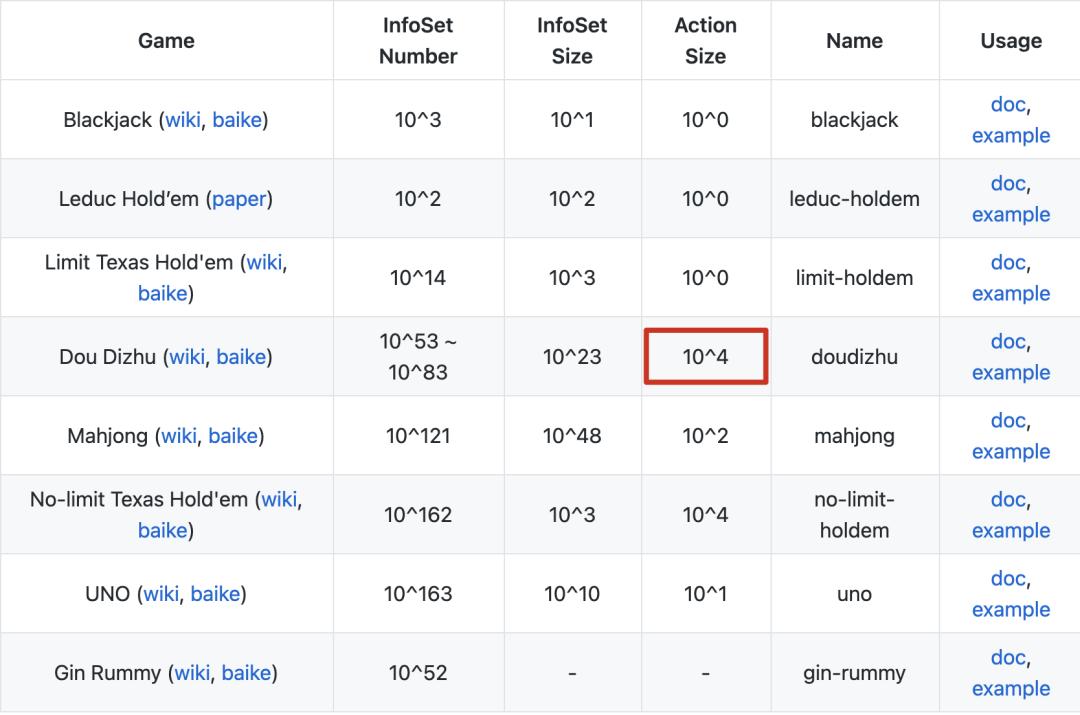

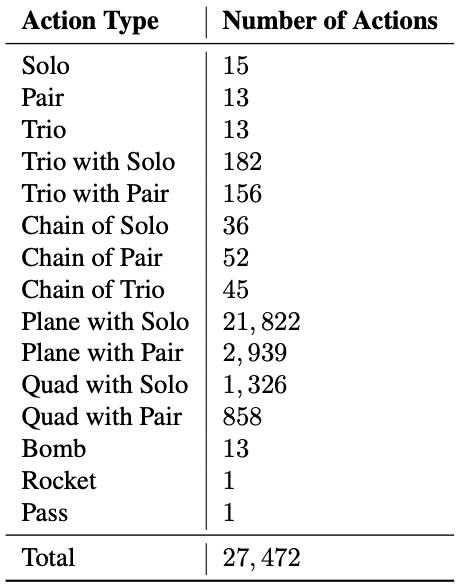

在棋牌游戏中,尽管斗地主的牌面信息量不及麻将,然而其可供选择的行动选项高达10的4次方,这一数字与德州扑克相仿。相比之下kaiyun全站网页版登录,大多数的强化学习算法仅能应对较小的行动空间。

斗地主的所有牌型总共有27472种可能。

像下图的手牌就有391种打法。

斗地主的操作难以概括,导致搜索所需的计算量极大,因此即便像Deep Q-Learning和A3C这样的强化学习算法,其胜率也仅有不到20%。

此外,在这种非对称的博弈中,若干农夫需在交流工具匮乏的条件下携手协作,共同对抗地主。

此类算法,如广泛应用的“反事实后悔最小化”策略,在模拟竞争与协作方面显得不够得心应手。

全局、农民和地主网络并行学习

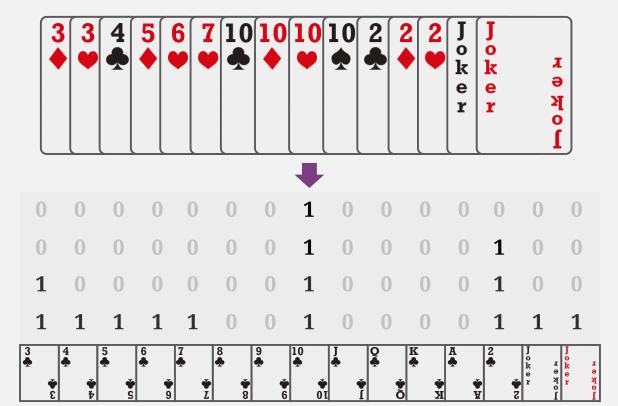

首先,需将手中的牌面信息转换成一种特殊的编码形式,即4x15的独热矩阵。在这种编码方式中kaiyun.ccm,每一种牌型最多包含四张,共计十五种不同的牌型。

DouZero是在对深度Q学习进行优化和升级的背景下诞生的。

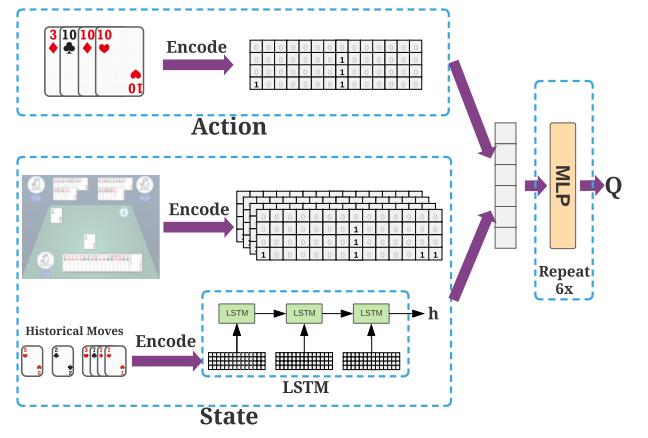

运用长短期记忆神经网络对过往出牌记录进行编码,同时采用独热矩阵对预测的牌局以及当前持有的牌进行编码,随后通过一个由6层组成、每层隐藏层维度为512的多层感知机计算Q值,从而确定最佳策略。

除了构建了涵盖所有“学习者”的总体网络之外,还额外设置了三个独立“角色”网络,它们分别模拟地主及其上下游的合作伙伴,并各自独立进行学习。这些网络之间通过一个共享的缓冲区,定期进行信息交流。

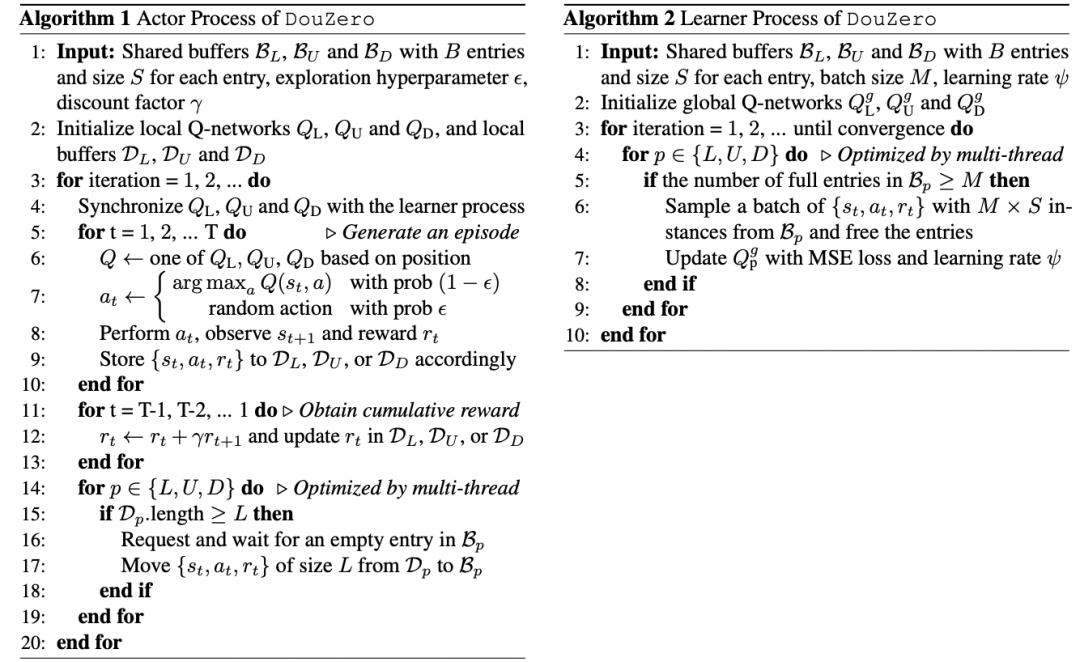

学习者和角色的算法

DouZero在装备有48个核心处理器的服务器上,以及搭载4块1080Ti显卡的强大配置支持下开yun体育app官网网页登录入口,经过10天的刻苦训练,成功击败了之前的冠军选手,从而晋升为最顶尖的斗地主人工智能。

下一步,加强AI间的协作

对于之后的工作,DouZero团队提出了几个方向:

一是尝试用ResNet等CNN网络来代替LSTM。

在强化学习领域,我们尝试采用Off-Policy学习策略,同时将目标策略和行为策略进行区分,以此目的在于提升训练的效率。

最终必须对农民之间的协作关系进行详尽的建模。哎呀,看来未来人工智能甚至能帮队友准备一杯卡布奇诺呢。

柯洁在遭遇AlphaGO的围棋挑战并败北之后,于2019年投身斗地主赛事,并最终荣获了冠军头衔。

不知道会不会有AI“追杀”过来继续挑战他。

在线试玩:

https://www.douzero.org